本文介紹了黑芝麻智能視覺(jué)與4D毫米波雷達(dá)前融合算法,通過(guò)多模態(tài)特征對(duì)齊和時(shí)序建模,顯著提升逆光、遮擋等復(fù)雜場(chǎng)景下的目標(biāo)檢測(cè)精度,增強(qiáng)輔助駕駛安全性。

隨著輔助駕駛技術(shù)逐步融入日常生活,其安全性成為社會(huì)關(guān)注焦點(diǎn),尤其在復(fù)雜交通場(chǎng)景中目標(biāo)檢測(cè)的穩(wěn)定性和準(zhǔn)確性成為行業(yè)研究核心。如何提升目標(biāo)檢測(cè)的準(zhǔn)確,穩(wěn)定性,成為了行業(yè)內(nèi)必須探討和研究的議題。不同目標(biāo)識(shí)別傳感器的選擇以及其配套的識(shí)別方案,對(duì)目標(biāo)檢測(cè)精度有著巨大的影響。

目標(biāo)識(shí)別傳感器選擇

多傳感器目標(biāo)檢測(cè)示意圖

目前主流的傳感器感知方案包括純視覺(jué)、激光雷達(dá)與相機(jī)融合以及新興的毫米波雷達(dá)與相機(jī)融合,這三種方案各有優(yōu)劣。

純視覺(jué)的檢測(cè)方案因其方便部署,硬件成本較低,具有較高分辨率等優(yōu)勢(shì),被廣泛應(yīng)用于目前各大主流輔助駕駛平臺(tái)中。然而,由于純視覺(jué)方案受光照、天氣等因素的影響較大,在夜間、逆光、雨雪霧等場(chǎng)景下,性能存在一定的局限性,且圖片無(wú)直接的深度信息,需要依賴單目/雙目估計(jì)的方法估算目標(biāo)距離信息,3D檢測(cè)精度有限;

相機(jī)激光雷達(dá)融合的方式,具有高精度3D感知,全天候工作的特點(diǎn),受到業(yè)界高端車型的青睞。但由于激光雷達(dá)硬件昂貴,量產(chǎn)車型成本壓力大,且在極端天氣下,激光束可能會(huì)發(fā)散,從而影響點(diǎn)云質(zhì)量,導(dǎo)致檢測(cè)精度下降;

相機(jī)毫米波雷達(dá)融合的方案,毫米波穿透性強(qiáng),在雨霧、沙塵等惡劣天氣下仍可穩(wěn)定工作,具有全天候工作精度較高的優(yōu)秀表現(xiàn)。此外,毫米波雷達(dá)硬件成本適中,其成本僅為激光雷達(dá)的1/3以下,且產(chǎn)業(yè)鏈成熟,適合規(guī)模化量產(chǎn)。

基于以上特點(diǎn),毫米波雷達(dá)相機(jī)融合的方案成為了行業(yè)新趨勢(shì)。基于AI的融合算法,如前融合點(diǎn)云投影、后融合目標(biāo)級(jí)關(guān)聯(lián)等逐步成熟。

行業(yè)毫米波雷達(dá)相機(jī)融合方案

輔助駕駛行業(yè)內(nèi),4D毫米波雷達(dá)相機(jī)融合方案正在加速落地,各頭部車企都有相應(yīng)的布局和應(yīng)用:

OEM廠商A:采用多模態(tài)融合架構(gòu),結(jié)合攝像頭、4D成像雷達(dá)和激光雷達(dá)。通過(guò)前融合和中融合的方式,融合多模態(tài)信息。前融合于原始數(shù)據(jù)層進(jìn)行融合,通過(guò)時(shí)空同步算法對(duì)齊雷達(dá)點(diǎn)云與圖像像素信息,提升三維重建精度;中融合于特征級(jí)進(jìn)行融合,使用ResNet-FPN網(wǎng)絡(luò)提取圖像“占用體積”特征,并將該特征與之前的特征相融合,產(chǎn)生4D占用網(wǎng)絡(luò),最后使用反卷積獲得體積及時(shí)序等反饋,從而實(shí)現(xiàn)動(dòng)態(tài)以及靜態(tài)的障礙物感知,增強(qiáng)目標(biāo)屬性的預(yù)測(cè)。多傳感器互補(bǔ),具有高冗余性,且因?yàn)橛欣走_(dá)高度信息的加持,可以覆蓋長(zhǎng)尾場(chǎng)景,如施工路段等,但多傳感器融合需要高算力支持,成本較高;

OEM廠商B:整合攝像頭、激光雷達(dá)、毫米波雷達(dá)、超聲波雷達(dá)等傳感器的數(shù)據(jù),構(gòu)建360°的環(huán)境感知能力。采用主流的BEV+Transformer技術(shù)方案,BEV負(fù)責(zé)將收集到的信息進(jìn)行前融合,Transformer負(fù)責(zé)對(duì)信息進(jìn)行處理。除此之外,疊加激光融合的GOD網(wǎng)絡(luò),擺脫大量人工規(guī)則的約束,可以穩(wěn)定識(shí)別小狗、減速帶和車庫(kù)閘門等,對(duì)于路旁異常出現(xiàn)的水管水柱也能進(jìn)行避讓;

傳統(tǒng)Tier1廠商A:使用毫米波雷達(dá)相機(jī)融合的方案,聚焦模塊化設(shè)計(jì),采用JPDA(聯(lián)合概率數(shù)據(jù)關(guān)聯(lián))算法,將雷達(dá)目標(biāo)與視覺(jué)檢測(cè)框通過(guò)IoU(交并比)和速度一致性匹配,提升目標(biāo)跟蹤穩(wěn)定性;通過(guò)eCalib工具實(shí)現(xiàn)雷達(dá)與相機(jī)的時(shí)空同步,誤差控制在+-5cm內(nèi),但該類的傳統(tǒng)規(guī)則融合算法迭代慢,泛化性差,較難支持高等級(jí)輔助駕駛需求。

黑芝麻智能融合團(tuán)隊(duì),采用了4D毫米波雷達(dá)和相機(jī)融合的方案,結(jié)合深度學(xué)習(xí)模型,提升了雨霧雪、黑夜、逆光等極端天氣和場(chǎng)景下目標(biāo)檢測(cè)的準(zhǔn)確性和穩(wěn)定性,改善了異形車、遮擋目標(biāo)等物體檢測(cè)的識(shí)別率,優(yōu)化了上下坡、匝道等三維空間存在變化的場(chǎng)景中目標(biāo)測(cè)距測(cè)速的精確性,顯著提升了輔助駕駛的安全性與可行性。

黑芝麻智能4D毫米波雷達(dá)相機(jī)融合方案

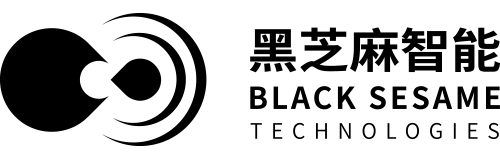

黑芝麻智能4D毫米波雷達(dá)相機(jī)融合方案,在BEV純視覺(jué)目標(biāo)檢測(cè)方案基礎(chǔ)上,添加4D毫米波雷達(dá)特征提取分支。4D毫米波雷達(dá)點(diǎn)云在經(jīng)過(guò)特征提取分支后,與圖像分支提取的圖像特征對(duì)齊并融合,組成時(shí)序信息,再經(jīng)過(guò)目標(biāo)head,輸出目標(biāo)相關(guān)的信息,其總體框架如下圖所示:

黑芝麻智能4D毫米波雷達(dá)相機(jī)融合框架示意圖

4D毫米波雷達(dá)特征提取模塊

模塊使用稀疏點(diǎn)云作為輸入,包含3D位置信息,RCS信息,速度信息等。經(jīng)過(guò)PointPillars骨干網(wǎng)絡(luò)提取點(diǎn)云的局部特征,再經(jīng)過(guò)基于Transformer的骨干網(wǎng)絡(luò)捕獲全局信息。PointPillars可以壓縮冗余信息,提取局部特征;RCS編碼增強(qiáng)目標(biāo)檢測(cè)的性能;Transformer強(qiáng)化關(guān)鍵特征,顯著提升稀疏點(diǎn)云的利用率。

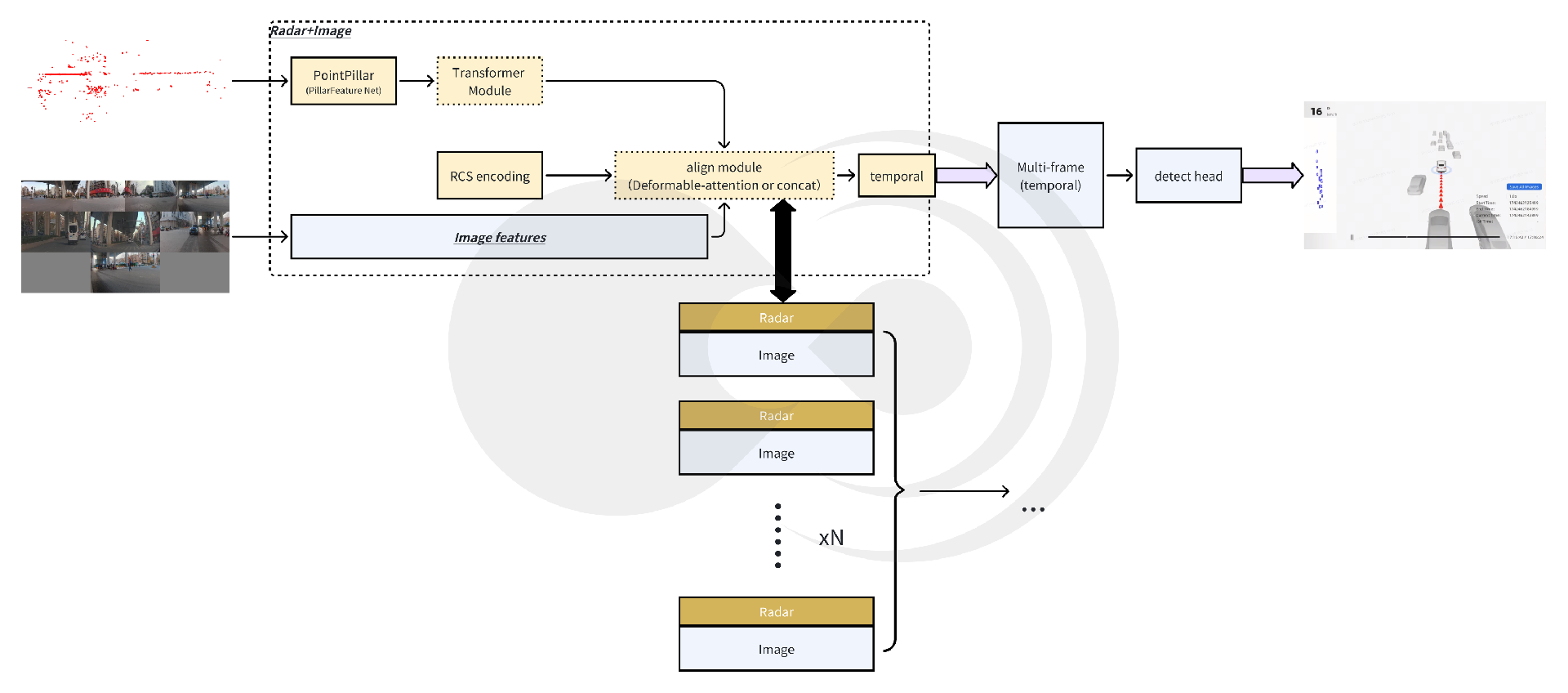

PointPillars提取點(diǎn)云局部特征

Pillar Feature Net提取點(diǎn)云特征示意圖

采用Pillar編碼的方式結(jié)構(gòu)化編碼毫米波雷達(dá),將無(wú)序的雷達(dá)點(diǎn)云劃分為規(guī)則的“柱狀”(Pillar)單元,每個(gè)柱體內(nèi)的點(diǎn)云通過(guò)簡(jiǎn)化特征(坐標(biāo)、反射強(qiáng)度等)編碼為固定維度的特征向量。通過(guò)局部特征聚合抑制噪聲,保留有效目標(biāo)信息,有效解決毫米波雷達(dá)點(diǎn)云稀疏且包含噪聲的問(wèn)題。針對(duì)多目標(biāo)檢測(cè),柱狀劃分可以有效地捕捉分散的雷達(dá)點(diǎn)云(如行人、車輛),提升對(duì)小型或遠(yuǎn)距離目標(biāo)的檢測(cè)能力。

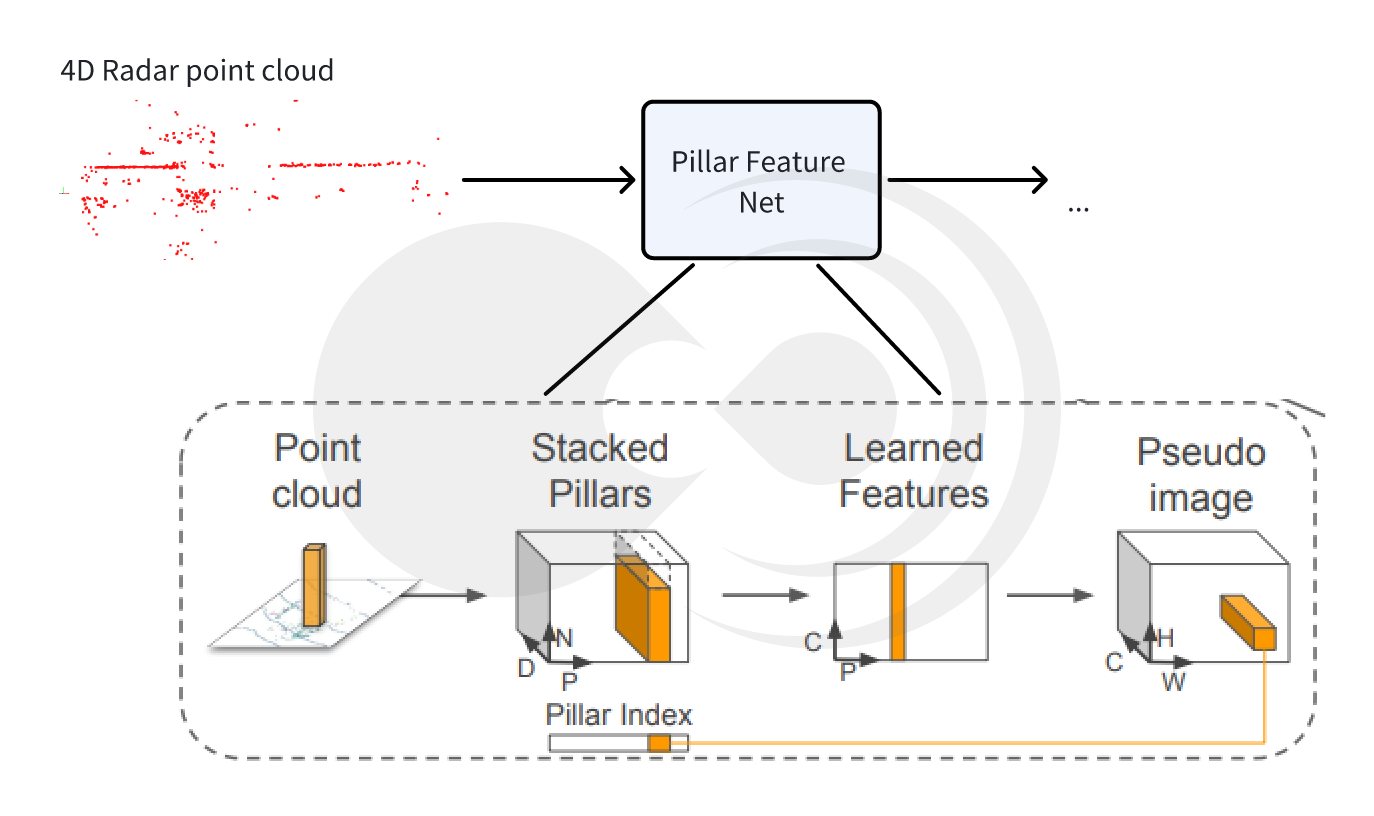

RCS編碼提升檢測(cè)性能

RSC編碼示意圖

采用基于RCS感知的BEV編碼器,利用雷達(dá)截面(RCS)能夠粗略衡量目標(biāo)尺寸的特性,有效解決因雷達(dá)生成的BEV特征是稀疏的而帶來(lái)的檢測(cè)性能損失問(wèn)題,即利用RCS作為目標(biāo)尺寸,將一個(gè)雷達(dá)點(diǎn)的特征分散到BEV空間中的多個(gè)像素而不是一個(gè)像素。

Transformer捕獲全局信息

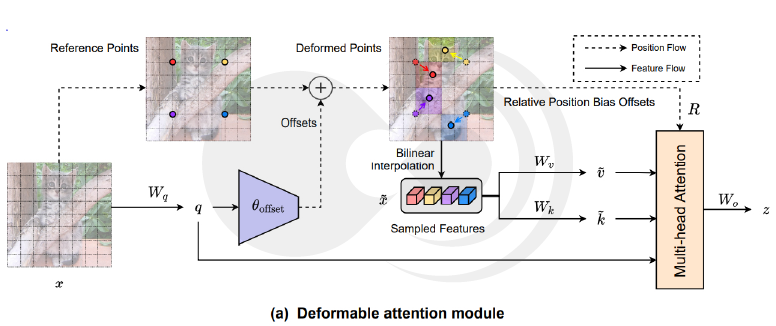

Deformable attention module

(圖片來(lái)源:《Vision Transformer with Deformable Attention》)

Transformer的子注意力機(jī)制可以跨柱體建立關(guān)聯(lián),捕捉場(chǎng)景中目標(biāo)之間的空間關(guān)系(如車輛與行人的相對(duì)位置),彌補(bǔ)傳統(tǒng)卷積網(wǎng)絡(luò)局部感受野的局限。并且采用動(dòng)態(tài)權(quán)重分配的策略,根據(jù)目標(biāo)重要性動(dòng)態(tài)調(diào)整特征權(quán)重,例如在擁堵場(chǎng)景中強(qiáng)化相鄰車輛的特征,抑制背景干擾。

多模態(tài)特征對(duì)齊時(shí)序模塊

多模態(tài)特征間的對(duì)齊問(wèn)題,一直是影響目標(biāo)檢測(cè)優(yōu)劣的關(guān)鍵因素。

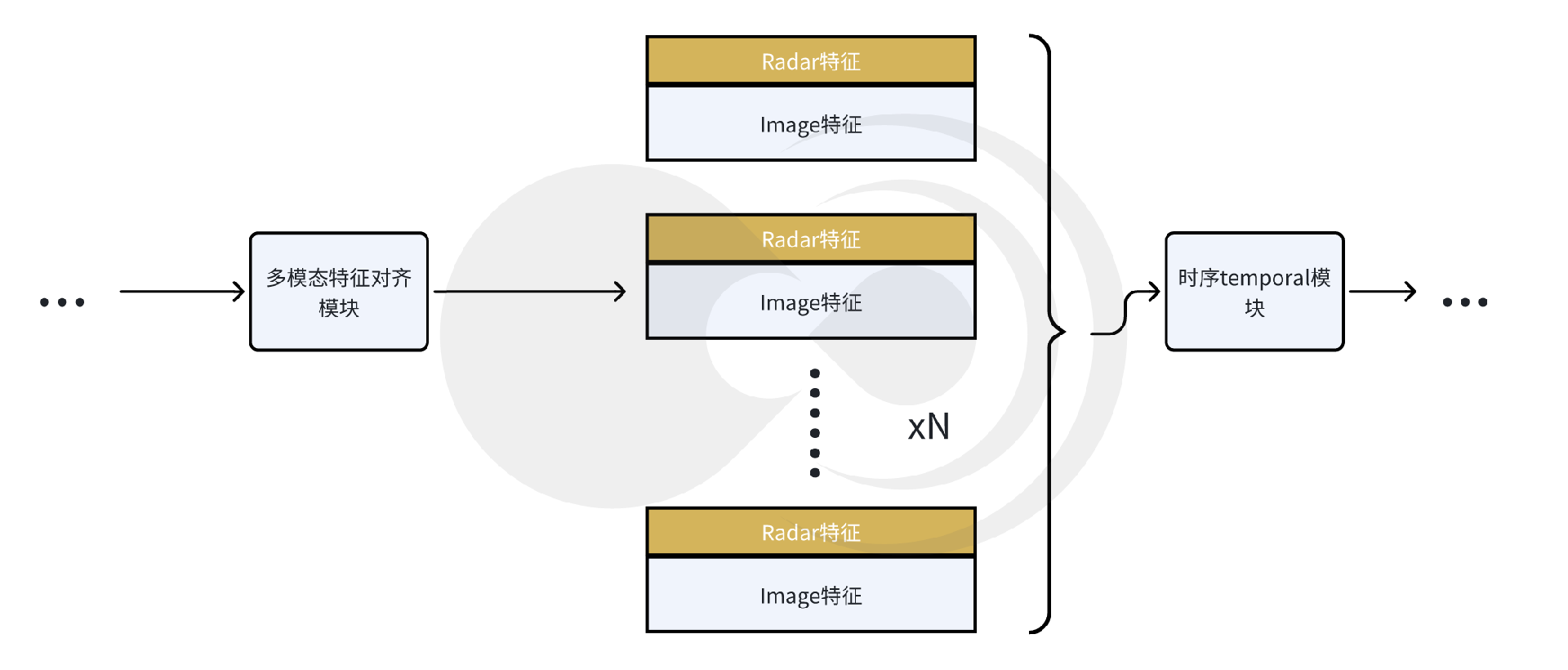

多模態(tài)特征對(duì)齊時(shí)序模塊示意圖

兼顧算力要求的多模態(tài)特征融合對(duì)齊

模塊通過(guò)接收?qǐng)D像特征提取骨干網(wǎng)絡(luò)的圖像特征以及毫米波雷達(dá)特征提取骨干網(wǎng)絡(luò)的雷達(dá)特征后,通過(guò)多模態(tài)特征對(duì)齊模塊,將二者融合為一體。通過(guò)特征拼接,操作計(jì)算量極低,能夠顯著降低硬件的算力要求。并且不對(duì)原始特征進(jìn)行壓縮或者變化,保留了特征的原始信息,避免信息丟失,適合需要高保真度的場(chǎng)景。如果需要較強(qiáng)的時(shí)序建模能力,且算力資源較為豐富,亦可采用多模態(tài)deformable attention的方式來(lái)實(shí)現(xiàn)對(duì)齊。

temporal模塊

按照時(shí)序添加temporal模塊,疊加多幀目標(biāo)的feature map,能夠有效的獲取目標(biāo)的時(shí)序信息,大大提升了目標(biāo)時(shí)序特征的準(zhǔn)確性和穩(wěn)定性,如位置、速度等。因采用多幀特征相結(jié)合的方式,能夠有效提升遮擋目標(biāo)的檢測(cè)準(zhǔn)確度。

測(cè)試指標(biāo)和結(jié)果展示

測(cè)試指標(biāo)說(shuō)明

模型的測(cè)試指標(biāo)主要通過(guò)以下幾個(gè)方面進(jìn)行對(duì)比:

mAP:mean Average Precision,評(píng)估目標(biāo)檢測(cè)模型的準(zhǔn)確性。它計(jì)算每個(gè)類別的平均精度(AP),然后對(duì)所有類別的AP進(jìn)行平均,常用于物體檢測(cè)任務(wù),如COCO數(shù)據(jù)集評(píng)估;

mATE:mean Absolute Trajectory Error,評(píng)估物體軌跡預(yù)測(cè)精度的指標(biāo)。它計(jì)算預(yù)測(cè)軌跡與真實(shí)軌跡之間的絕對(duì)誤差的平均值,常用于運(yùn)動(dòng)預(yù)測(cè)和計(jì)算機(jī)視覺(jué)中的跟蹤任務(wù);

mAVE:mean Average Velocity Error,評(píng)估物體速度預(yù)測(cè)的指標(biāo)。它計(jì)算預(yù)測(cè)速度與真實(shí)速度之間的誤差的平均值,常用于動(dòng)態(tài)場(chǎng)景的分析和預(yù)測(cè)。

結(jié)果

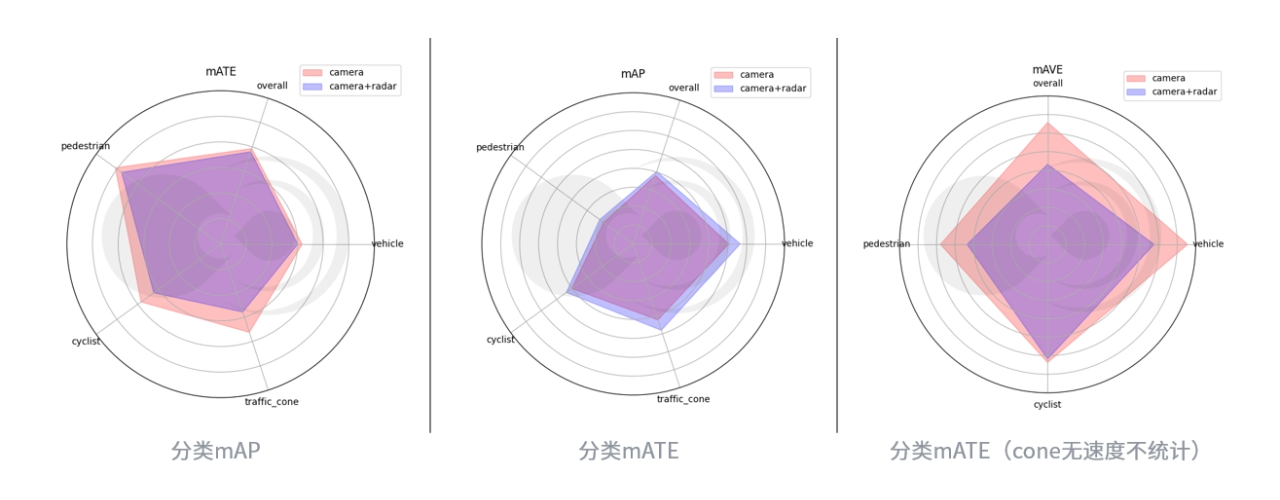

分類測(cè)試指標(biāo)

經(jīng)過(guò)測(cè)試,相較于純視覺(jué)模型,4D毫米波雷達(dá)相機(jī)融合模型,在縱向100米(自車前方),橫向+-32米范圍內(nèi),mAP提升5%,mATE提升2.5%,mAVE提升明顯33.85%。

典型場(chǎng)景展示

在許多極端場(chǎng)景下,目標(biāo)檢測(cè)的精度,在融合4D毫米波雷達(dá)特征后,得到了顯著提升。

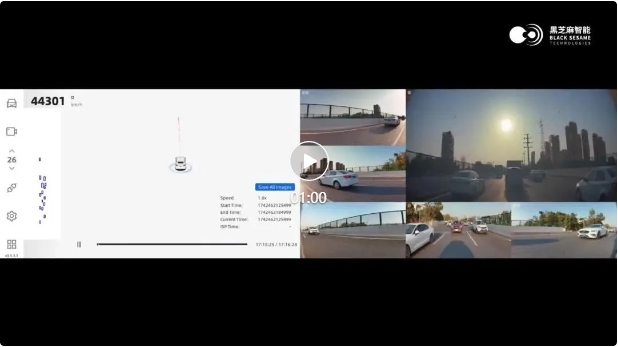

逆光漏檢

逆光場(chǎng)景下,由于車輛和背景對(duì)比度降低,純視覺(jué)方案難以穩(wěn)定檢測(cè)出目標(biāo)。在融合毫米波雷達(dá)的信息后,逆光場(chǎng)景檢測(cè)率提升12%。

在下述例子中,前方車輛均呈現(xiàn)黑色紋理消失,前前大貨車純視覺(jué)方案漏檢,若前前車切出,可能因前前車目標(biāo)位置速度收斂慢,導(dǎo)致自車急剎車,4D-radar利用其回波不受光照影響都特性,順利補(bǔ)回前方目標(biāo)。

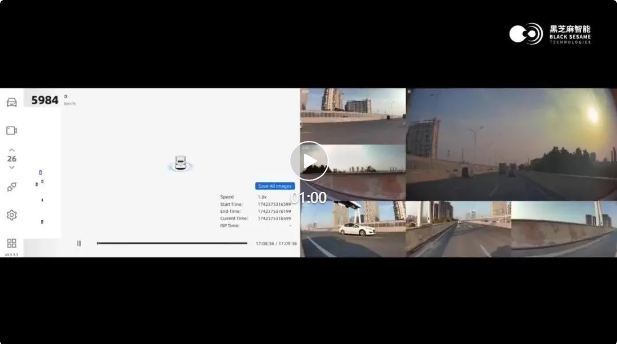

(0′03″處前前貨車丟失補(bǔ)回)

純視覺(jué)模型

4D毫米波雷達(dá)相機(jī)融合模型

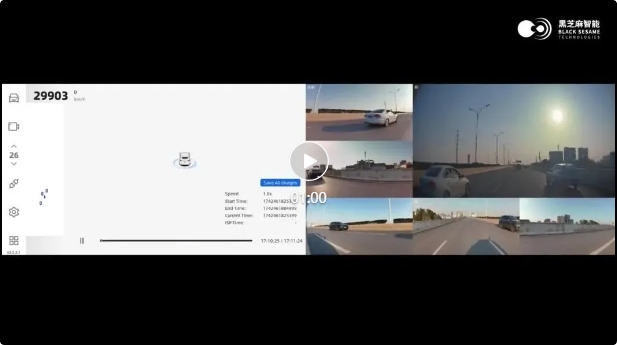

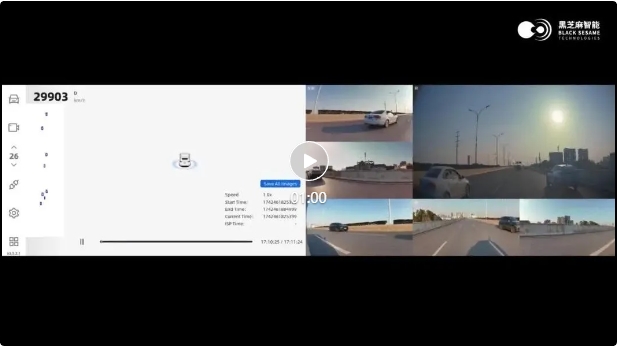

遮擋漏檢

在被遮擋的情況下,純視覺(jué)方案難以檢測(cè)到明確的目標(biāo)特征,因此可能會(huì)導(dǎo)致漏檢。在添加毫米波雷達(dá)的特征后,能夠有效提升遮擋目標(biāo)的檢測(cè)率,相比于純視覺(jué)方案,提升7%。

在下述例子中,左側(cè)前方目標(biāo)由于遮擋導(dǎo)致無(wú)法順利檢出,若左側(cè)前方目標(biāo)向右cut-in自車可能無(wú)法及時(shí)響應(yīng)減速。毫米波利用穿透特性,有效實(shí)時(shí)檢測(cè)間隔目標(biāo),給自車響應(yīng)預(yù)留充足時(shí)間。

(0′20″左前方遮擋丟失目標(biāo)補(bǔ)回)

純視覺(jué)模型

4D毫米波雷達(dá)相機(jī)融合模型

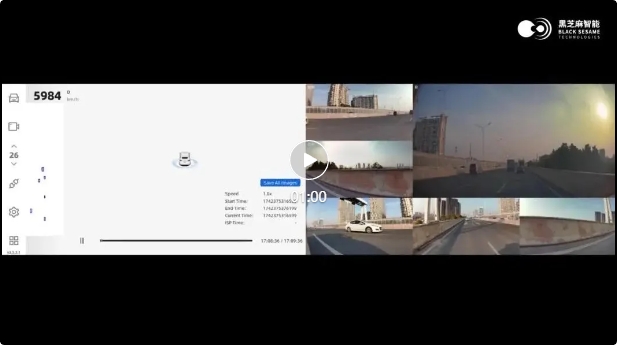

匝道場(chǎng)景

匝道場(chǎng)景下,由于目標(biāo)和自車可能處于非同平面,純視覺(jué)系統(tǒng)依賴單目或雙目相機(jī)平面投影模型對(duì)目標(biāo)的位置信息進(jìn)行估算,易受透視畸變的影響,導(dǎo)致測(cè)距測(cè)速精度下降。在結(jié)合毫米波雷達(dá)的3D信息后,在非同平面專項(xiàng)場(chǎng)景下(上下坡場(chǎng)景),目標(biāo)測(cè)距測(cè)速準(zhǔn)確率提升9%以上。

在下述例子中,下匝道場(chǎng)景4D毫米波雷達(dá)相機(jī)融合方案將遠(yuǎn)處貨車補(bǔ)回,并輸出更加穩(wěn)定的位置、速度信息。

(0′26″前前貨車丟失補(bǔ)回分裂消失)

純視覺(jué)模型

4D毫米波雷達(dá)相機(jī)融合模型

4D毫米波雷達(dá)具有全天候,成本適中,產(chǎn)業(yè)鏈較成熟等特點(diǎn),目前正在成為行業(yè)內(nèi)多模態(tài)融合目標(biāo)檢測(cè)任務(wù)中的重要傳感器。實(shí)驗(yàn)結(jié)果表明,4D毫米波雷達(dá)相機(jī)融合方案,相較于純視覺(jué)目標(biāo)檢測(cè)方案,有效提升了目標(biāo)檢測(cè)的精度,改善了純視覺(jué)模型測(cè)距測(cè)速的性能,特別是極端場(chǎng)景下模型的表現(xiàn),如光線局限場(chǎng)景、遮擋場(chǎng)景以及非同平面場(chǎng)景等,提升輔助駕駛的駕駛安全性。